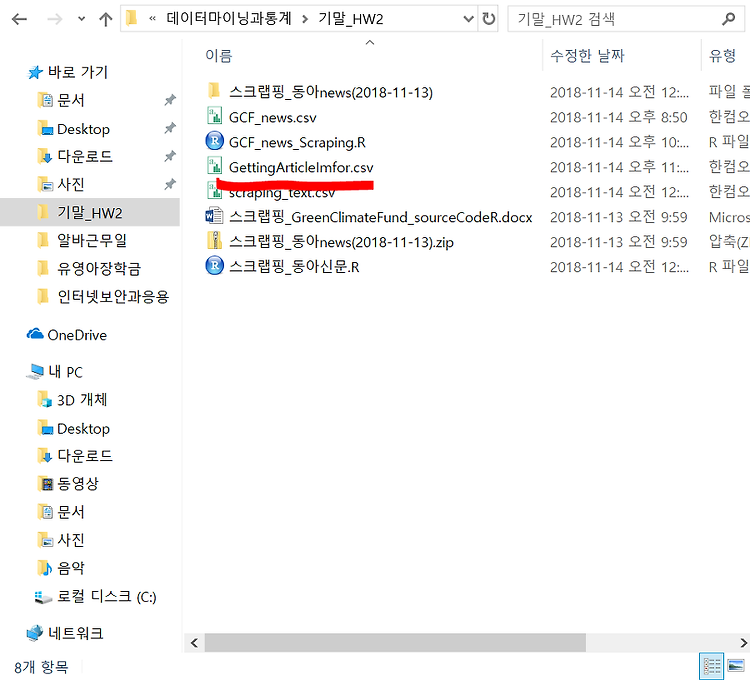

오늘은 웹 크롤링한 데이터를 csv ( 엑셀 ) 형태로 저장을 시키고 , 저장시킨 엑셀 파일을 정제시키고 , 데이터를 가져와서 시각화 해보는 작업을 해 볼 것이다. 내가 크롤링할 사이트는 https://www.greenclimate.fund/home 이며 영어로 된 뉴스 사이트다. 코드를 보면서 분서해 보자 . 크게 rvest 패키지와 XML패키지가 필요하며 시각화 할 때 필요한 wordcloud2 패키지가 필요하다 . 문서를 다루는 tm패키지가 보통 깔려있는데 , 나는 없어서 깔아 주었다. library(rvest)library(XML) # 크롤링을 해오기 위해서 필요한 라이브러리들 install.packages("tm")install.packages("wordcloud2") # 필요한 패키지들 #wo..

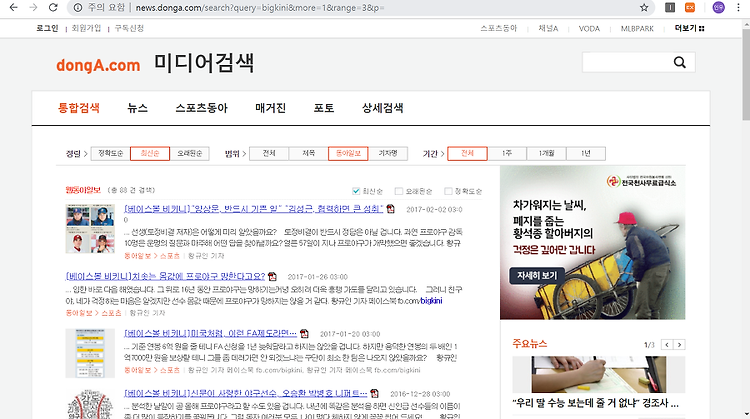

동아 신문 사이트를 스크랩핑해보는 시간을 가져볼 것이다. 소스 코드는 다음과 같다. library(rvest)library(dplyr)우선 기본적으로 rvest 와 dplyr 패키지를 로딩시켜준다. url % html_nodes('a') %>% html_attr('href') %>% unique()) }이제 for문을 사용해서 html 코드 내에 있는 값에 접근을 해볼 것이다.먼저 html_read로 6개의 값이 저장되어 있는 url을 html 코드로 가져온다.그리고 나서 searchContent_class 명인것에 접근을 하고 , 그 하위 node인 클래스 a인 노드들에 접근하며 , 그 하위 노드의 attr = href 의 값을 가지는 노드를 추출한다 . 이때 unique를 사용함으로써 중복 방지를 한..